En la década de los 90, cuando se echaba mano del socorrido símil autopistas de la información para entender qué es lo que podría aportar a futuro la World Wide Web (que acabó reducida a Web o Red), se nos prometió un El Dorado donde el acceso a la información será universal y barato. Sin embargo, ese paraíso futurible donde todavía el acceso era caro y con unas necesidades tecnológicas aún lejanas para la inmensa mayoría de la población pronto mutó hacia otra cosa mientras el dinero comenzó a fluir hacia un entorno que lo redefiniría todo.

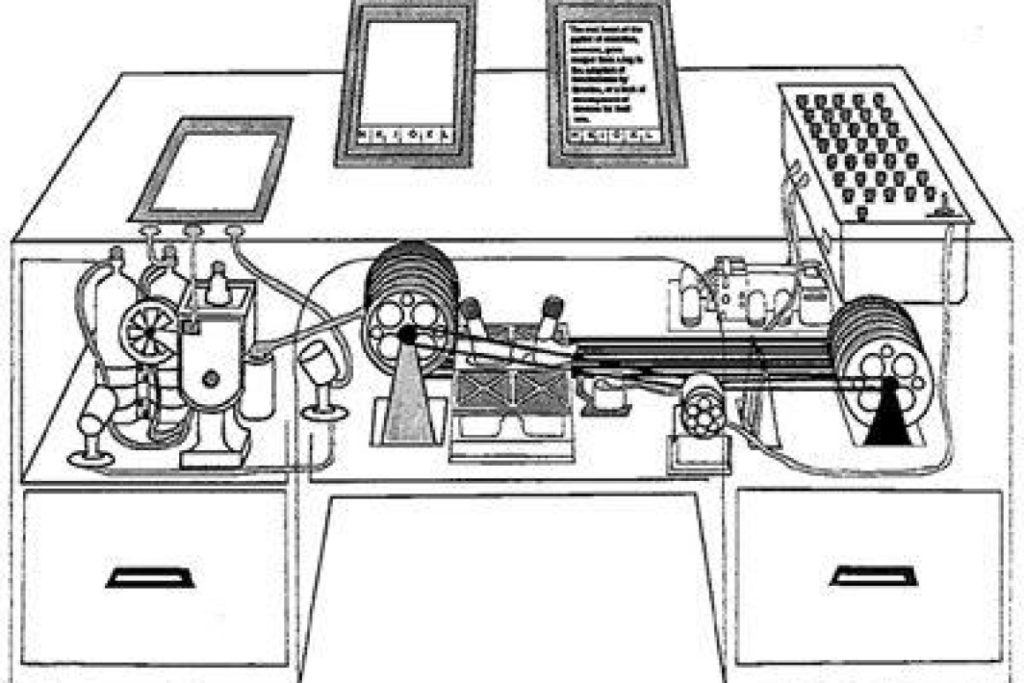

En una primera fase, la recopilación de enlaces de sitios interesantes en forma de directorios fue sencillo de mantener. Pero pronto esa curación humana se tornaría inmanejable dando espacio a otro tipo de tecnologías como la de En una segunda, Google que acudió a salvarnos frente aquella intoxicación, haciendo racional y sencillo la categorización de la información mediante algoritmia y una serie de rankings que fueron cambiando a lo largo del tiempo. Esta clasificación automática tuvo que ir adaptándose a la realidad de una web que crecía y se bifurcaba hacia todo tipo de contenidos e intereses según se democratizaba la generación de contenido (Web 2.0) y el acceso sencillo e inmediato en cualquier punto (teléfonos móviles).

Cada nueva evolución tecnológica significaba un cambio del paradigma anterior, pero la Web supo pudiendo ofrecer soluciones de información a todo tipo de sensibilidades y de esperanzas. Hubo un momento que la Web era un foro abierto en que cualquier persona tenía una oportunidad para promocionarse, opinar de forma transparente y mostrar sus conocimientos. Con suerte, hasta poder construir una comunidad propia, pero el modelo se fue retorciendo según se añadían capas y capas nuevas al algoritmo y el ecosistema móvil se posicionaba como una nueva gallina de los huevos de oro, según las marcas buscaban llegar a consumidores jóvenes y no tanto. Por supuesto que los mensajes y la capacidad de influir a la opinión pública también cambiaba; trasladándose desde los medios de comunicación y hacia Facebook y, en menor medida, a Twitter entonces y ahora X.

Por si la situación no fuese compleja, y con las redes sociales ya siendo sometidas a escrutinio y control debido a su alcance a la población en general, otra capa de complejidad se añade apoyándose en todo lo anterior. La Inteligencia Artificial viene a incorporar un poco más de confusión a todas esas vías de acceso de información a los usuarios. Ya se trate mediante texto o imagen (en la mayor brevedad vídeo), las IAs se posicionan como grandes generadores de textos que de forma barata son capaces de sobrepasar al resto de generadores de contenidos ya sean medios de comunicación como referentes de la opinión pública individuales.

[Continúa]

Un comentario